👋 Hoi, Ed en Chris hier. In de Atlas van het Lange Nu duiden we de snel veranderende wereld vanuit een langetermijnperspectief. Hoe begrijpen we onze tijd als we verder kijken dan dagkoersen, kwartaalverslagen en verkiezingscycli? Als we het moment waarin we denken te leven oprekken tot decennia, eeuwen of millennia – wat zien we dan?

Vandaag een verkenning van de snel veranderende wereld van kunstmatige intelligentie. De afgelopen tijd lijkt het er namelijk op dat deze technologie het laboratorium nu definitief aan het ontgroeien is, door enorm grote en breed toepasbare AI-modellen. Maar wat betekent dit?

De Opkomst van Industriële Denkkracht

🔌

Veel technologische uitvindingen die een enorme impact hebben gehad op onze samenleving zijn tot op zekere hoogte onzichtbaar geworden. Ze zijn zo alledaags, zo verweven met alles wat we doen, dat we makkelijk vergeten hoe fundamenteel ze zijn voor ons bestaan. Denk aan elektriciteit, de spoorwegen, de boekdrukkunst, de verbrandingsmotor, de computer of het internet. Dit soort technologieën staan ook wel bekend als General Purpose Technologies, en wanneer er een uitgevonden wordt, veranderen samenlevingen. Probeer je maar eens voor te stellen hoe een wereld eruit zou zien als het nederige stopcontact nergens meer te vinden zou zijn.

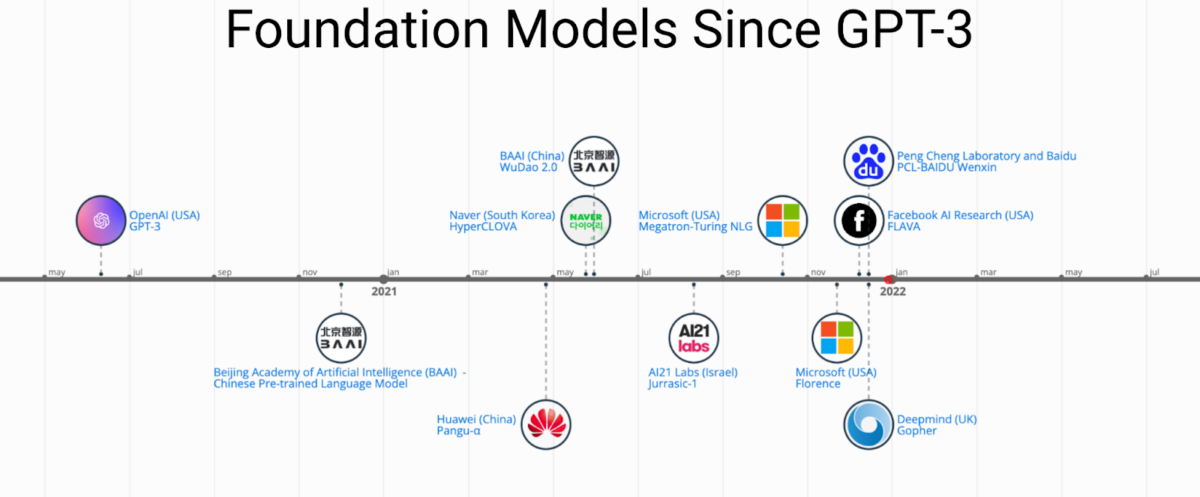

Volgens velen is Artificial Intelligence, of kortweg AI, nu op een punt aangekomen dat het een General Purpose Technology gaat worden. Veel van de AI, of om preciezer te zijn, de machine learning-modellen die gebouwd zijn met neural networks, hadden tot nog toe vrij nauwe toepassingen, zoals herkenning van gezichten, spraak of tekst, het afmaken van woorden met autocomplete, of het besturen van een auto. Dit is als het ware ambachtelijke AI, ontwikkeld door teams van slimme programmeurs, gevoed met specifieke data die gelabeld zijn door mensen, om specifieke taken te leren. Maar het afgelopen jaar is AI industrieel geworden, de modellen worden steeds groter, slimmer en makkelijker toe te passen in allerlei nieuwe contexten.

Deze AI-modellen op industriële schaal worden Foundation Models genoemd. Het zijn enorme AI-modellen die gevoed zijn door enorme hoeveelheden ongelabelde en (deels) ongestructureerde data, zoals websites, boeken, video’s en foto’s. De AI zoekt daar vervolgens zelf structuren en patronen in zonder supervisie. Door statistische relaties te ontwaren, leert het model hoe taal werkt, wat wiskunde is, en wat het verschil is tussen een Dalí en een Vermeer. Behalve dat deze modellen groot zijn en een aardige intelligentie vertonen in uiteenlopende domeinen (van schaken tot essay’s of code schrijven en het creëren van foto’s en illustraties op basis van een beschrijving) kan iedereen zijn eigen toepassingen erop bouwen en het op die manier inpassen voor eigen gebruik.

Wat gaat dit betekenen?

Het is nog vroeg, maar wat deze modellen al kunnen is erg indrukwekkend, ook al maken ze vaak ook nog gekke bokkensprongen (rare zinnen, unheimische beelden, onherkenbare uitspraken). Maar veel van deze foundation models zijn relatief makkelijk te gebruiken en te integreren (via API’s) in apps en andere digitale processen. GPT-3, een foundation model waar afgelopen jaar veel buzz over was, kun je hier zelf uitproberen (je kan inloggen met een Google- of Microsoft-account). Dat betekent dat allerlei ontwikkelaars nu heel makkelijk AI kunnen gaan integreren in hun toepassingen. De komende jaren zul je dus in allerlei apps, op websites en bij alles wat op software draait steeds meer, en steeds slimmere AI tegen gaan komen. Hieronder een korte speculatieve verkenning, onderbouwd met wat mensen nu al aan het maken zijn.

Je Persoonlijke Sparringpartner

💬

Stel, je bent een academicus en je doet onderzoek naar middeleeuwse symboliek. Je begint met een foundation model en daarbovenop laat je het model al je geschreven werk lezen en alles wat je ooit las. Vervolgens ga je aan het werk met je kunstmatige intelligente onderzoeksassistent. Een samenwerking waarin de AI met je meeschrijft, zinnen parafraseert, bronnen aandraagt en misschien zelfs met je brainstormt om nieuwe richtingen voor je onderzoek te verkennen. Misschien kan de AI zelfs de hele paper voor jou schrijven waarbij je ‘m alleen maar hoeft te corrigeren en feedback te geven, waarna je de volgende iteratie krijgt. Hoe meer je in het model stopt, hoe slimmer je kunstmatige metgezel wordt. Hoe langer deze AI met jou mee-leert, en hoe meer literatuur, manuscripten, en beeldarchieven het absorbeert, hoe slimmer en dieper de inzichten van de AI zullen zijn. Althans, dit is de belofte.

Overigens is deze richting misschien ook wel nodig om wetenschappelijk onderzoek uit het slop te trekken. Azeem Azhar wees ons op ‘Science is getting harder’, een essay van Matt Clancy waarin hij bewijs verzamelt dat de ontdekkingen die gedaan worden gemiddeld genomen kleiner worden. Allicht heeft het iets te maken met de uitdaging om voort te bouwen op een almaar uitdijende en complexer wordende hoeveelheid kennis. Is het ontwikkelen van nieuwe kennis op de lange termijn nog doenbaar als je enkel gebruik maakt van menselijke denkkracht?

📊 SpreadSheet Magic — Waarom zelf data opzoeken? Met deze GPT-3 add-on vult de AI de data die je wil hebben automatisch in (zie hierboven). Dit is vooral een experimenteel prototype, en de data klopt niet altijd, maar het maakt de potentie goed duidelijk. [link]

👓 Elicit — Een AI onderzoeksassistent gebouwd op GPT-3. Helpt je papers tevinden en kan met je brainstormen over onderzoeksrichtingen. [link]

Je Eenpersoons Superstudio

🎨

Stel, je bent een illustrator die in opdracht tekeningen maakt. Je gebruikt een visueel foundation model en die voer je ook al jouw tekenwerk, waardoor het model zich ook jouw herkenbare handschrift eigen kan maken. Vervolgens kan je het schetsen voeren, of simpelweg omschrijvingen en ideeën over wat de tekening moet vertellen of laten zien. Vervolgens poept de AI eindeloos veel iteraties uit, die je telkens kan finetunen qua kleur, compositie, etc. Samen met deze digitale tovenaarsleerling ben je opeens een studio geworden die meer en sneller kan produceren dan je ooit in je eentje kon.

Dit soort tools vinden al hun ingang in de game- en filmindustrie, aangezien hier met grote teams van tekenaars en creatievelingen gewerkt wordt en er ontstellend veel materiaal geproduceerd moet worden. Het werk is hier al specialistisch en op massaproductie ingericht, met tekenaars die alleen achtergronden, gadgets, karakters, voertuigen, beesten of architectuur doen.

Colie Wertz, een concept artist die voor producties zoals Star Wars en Dune werkte, vertelt in deze podcast bijvoorbeeld hoe hij landschappen tekent met een GauGAN, het neurale netwerk waar Nividia’s Canvas-app op draait. Hiermee tekent hij landschappen in minuten in plaats van uren.

🖼 Nvidia Canvas/GauGAN — Een AI beeldcreatietool om landschappen mee te maken (zie hierboven). Is gratis te downloaden voor Windows of je kan er hier online mee spelen. Verschillende partijen hebben hier inmiddels foundation models voor gebouwd. Deze toepassing zal dus niet beperkt blijven tot landschappen, maar straks kan je elk beeld maken in welke stijl je maar wilt, van fotografische beelden tot een Rembrandt-schilderij.

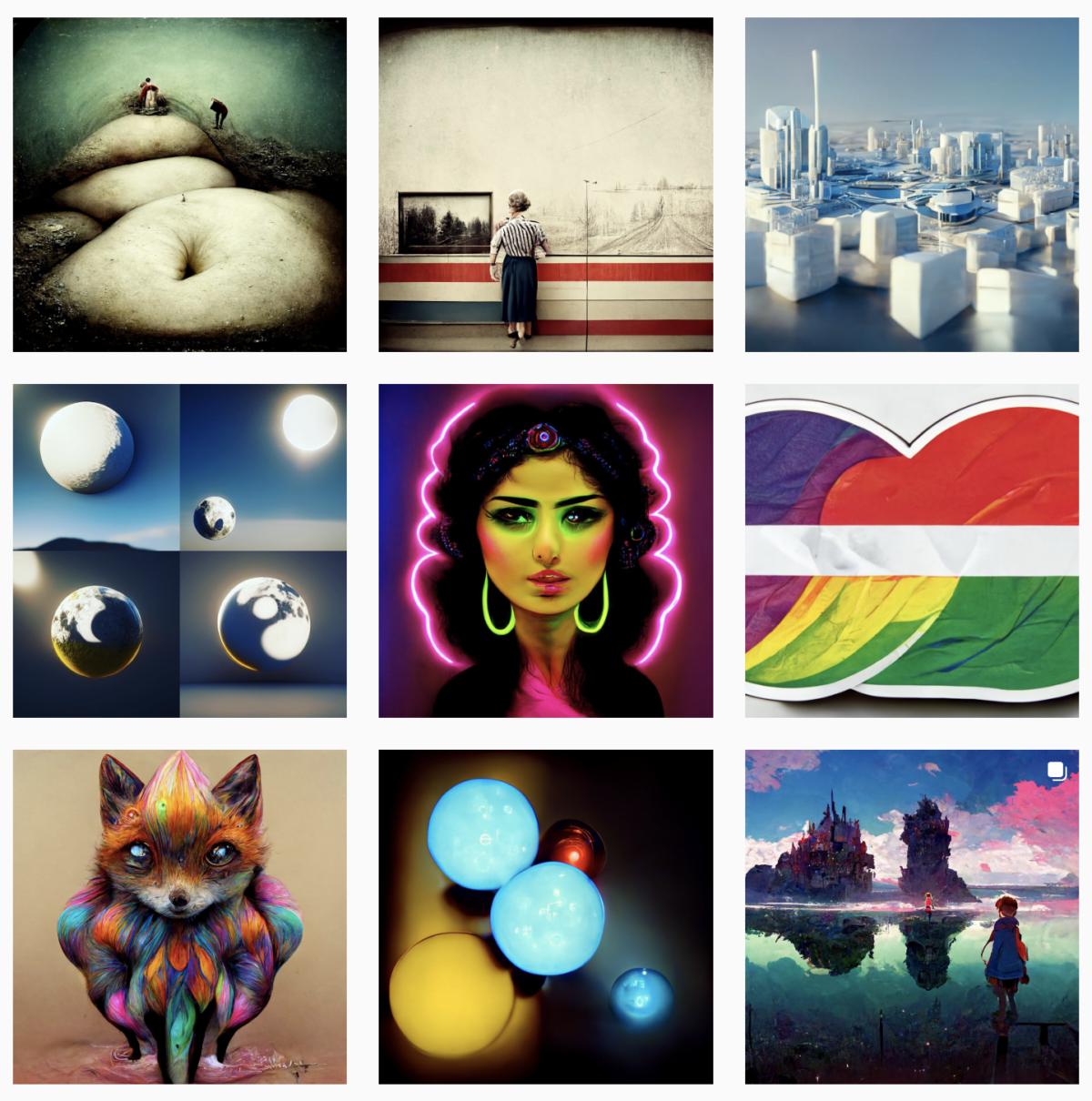

Van OpenAI is er Dall-E 2 (wachtlijst), Google maakte Imagen (niet openbaar toegankelijk) en dan is er nog het artistiekere Midjourney (wachtlijst). Voor een goeie uitleg hoe dit allemaal werkt en waartoe deze modellen in staat zijn is deze video van Vox een aanrader.

#midjourney op instagram

Brave New Brain

🧠

Voordat we in de nieuwe problemen en uitdagingen duiken die het loslaten van industriële denkkracht in onze samenleving met zich meebrengen, nog even het meest extreme vergezicht: de Neural Lace, een brein-computer-interface die onder je schedeldak wordt ingebracht en waarmee jouw brein direct toegang kan krijgen tot een enorme hoeveelheid capaciteiten en mogelijkheden die AI te bieden heeft. Deze neural lace bestaat nog niet, maar Neuralink, het bedrijf van Elon Musk (die overigens ook OpenAI oprichtte, de makers van Dall-E 2 en GPT-3) is deze technologie aan het ontwikkelen.

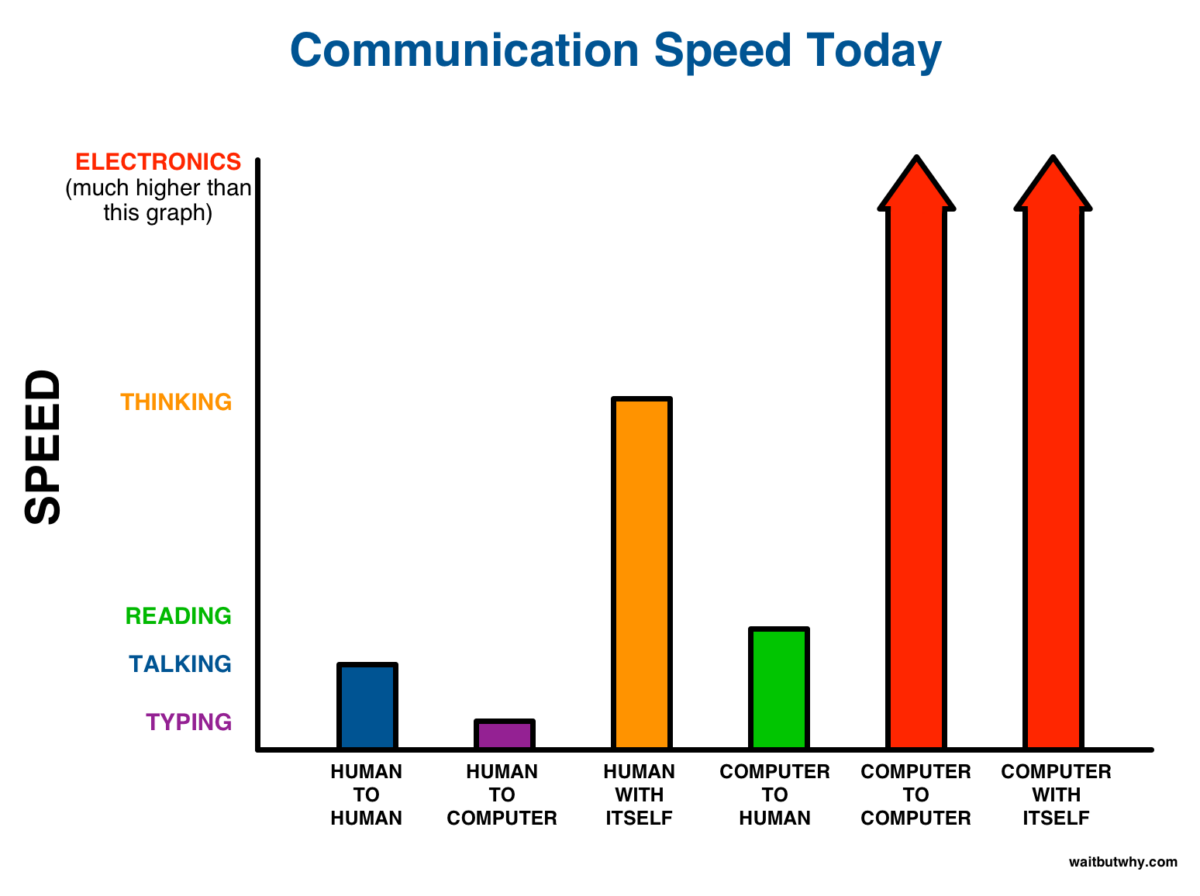

De trans-humanistische logica achter dit project is als volgt: als AI steeds beter wordt dan lopen we als mensen uiteindelijk tegen een beperking aan. De snelheid waarmee we kunnen communiceren met een AI is namelijk beperkt tot onze spreeksnelheid, of de snelheid waarmee we met onze tien vingers via een toetsenbord of een ander input-apparaat kunnen communiceren met de betreffende AI. Als we optimaal gebruik willen maken van de denkkracht van AI dan moeten we deze smalle communicatiebandbreedte tussen ons biologische brein en het kunstmatige brein zien op te lossen. Musks oplossing, die overigens geïnspireerd is op de neural lace uit de sciencefiction van Ian M. Bank, is het brein direct op neurologisch niveau in contact te brengen met een externe kunstmatige hersenkwab, AI.

Wat dit betekent, en of we dit willen, is uiteraard een belangrijke discussie. Maar voordat je compleet in de weerstand schiet van het idee dat je sociale media straks letterlijk in je brein zit, is het goed om eens te verkennen hoe dit zou kunnen werken en hoe het zou kunnen voelen als je brein opeens groter is dan je hoofd. Wat als in jouw bewustzijn je eigen gedachten samen komen met die van andere (kunstmatige) breinen? Hoe voelt het om opeens dingen te weten die je nooit geleerd hebt? Kun je het verschil voelen tussen of een idee uit je eigen geest, of uit je kunstmatig intelligente hersenkwab kwam? Dit zijn nogal trippy vragen, maar als je deze rabbit hole in wil duiken dan is deze (enorme) long read van Tim Urban van Wait But Why een absolute aanrader: Neuralink and the Brain’s Magical Future.

Nieuwe technologie, nieuwe problemen

💥

Hoewel dit natuurlijk allemaal interessante nieuwe mogelijkheden voor makers en denkers biedt en fascinerende vergezichten oplevert, ontstaan er met de komst van deze nieuwe General Purpose Technology natuurlijk ook allerlei nieuwe problemen. Een kleine selectie (er zijn er vast meer):

🔀 Bias — Foundation models hebben bizar veel data nodig om goed te functioneren. Het internet is het curriculum waarmee deze modellen zonder supervisie leren en daarmee ‘leren’ ze ook alle ideeën die er te vinden zijn, van diepe filosofische waarheden tot flat earth theorieën en het feit dat CEO’s over het algemeen witte mannen zijn. Als deze foundation models een basisinfrastructuur worden, wordt ook het biasprobleem groter.

💪 Machtsconcentratie — Om foundation models te trainen heb je enorm veel rekenvermogen nodig. Het kost nu een tiental miljoen euro’s om een model te trainen. Dat betekent dat alleen grote vermogende partijen dit kunnen doen. Dan gaat het niet alleen om Big Tech, ook natiestaten doen mee in wat een soort nieuwe race is geworden.

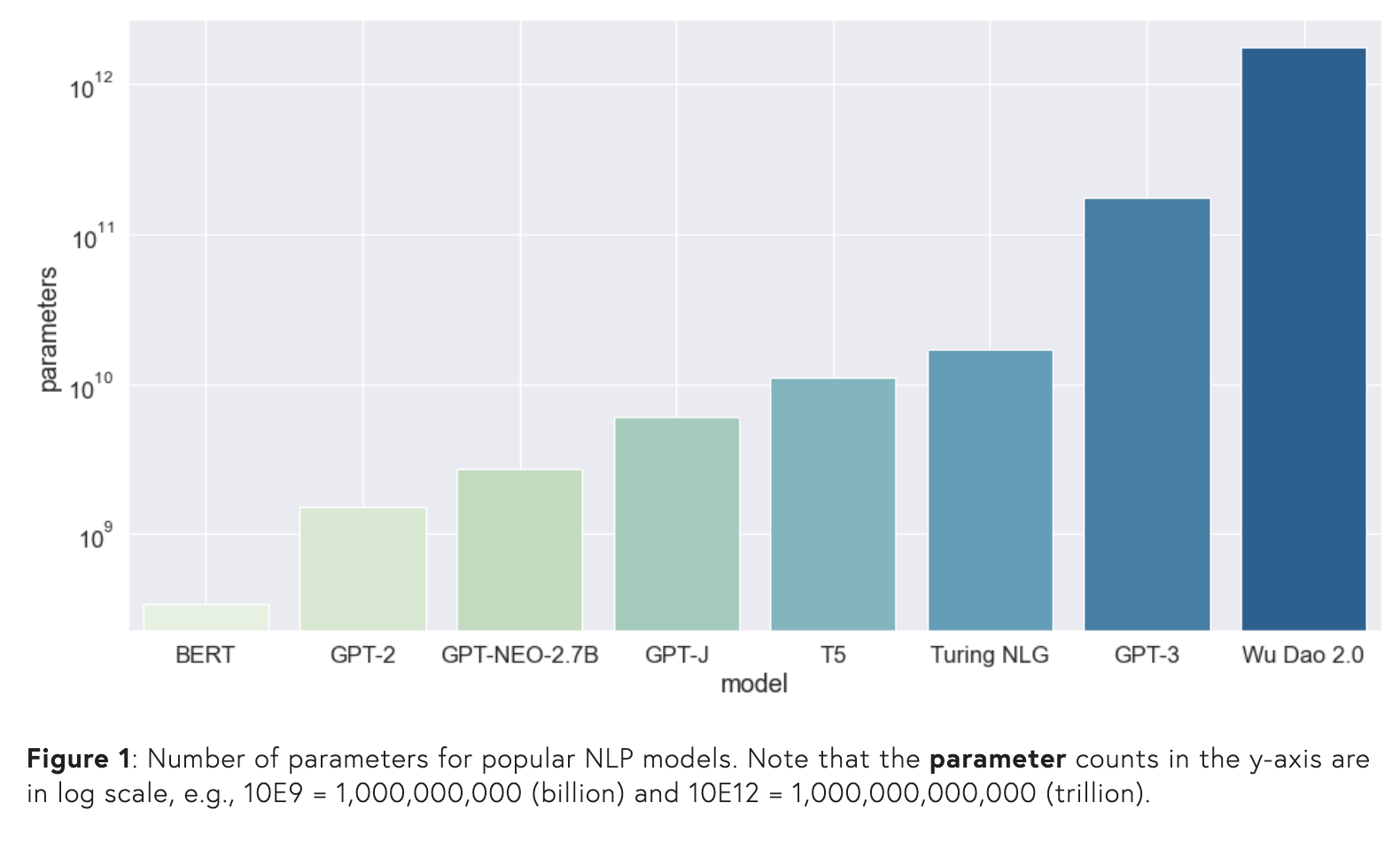

Uit On the Opportunities and Risks of Foundation Models (Stanford University, 02021)

✍️ Auteursrecht — Met deze technologie kan je uiteindelijk een film in de stijl van Disney of Pixar maken zonder auteursrechten te overtreden. Of de concurrent van een illustrator kan werk in zijn stijl gaan maken en verkopen zonder de wet te overtreden. Want een bepaalde esthetiek of stijl is niet wettelijk te beschermen. Althans, nog niet.

🤝 Vertrouwen — Wanneer het in ons medialandschap totaal onduidelijk is of er achter het beeld dat we zien, een tekst die we lezen (of zelfs een gedachte die we hebben) een mensenhand of een robotbrein zit, waar vertrouwen we dan op? Want impliciet ligt een groot deel van ons vertrouwen in de publieke sfeer ook in het feit dat er achter iedere uiting een mens zit, een bewustzijn met een geweten, een persoon die onderdeel is van een gemeenschap en een gedeelde cultuur. Het zijn individuen die uiteindelijk kunnen worden aangesproken op hun handelen. Maar hoe houd je een AI verantwoordelijk? En kan een AI uitleggen waarom het deed wat het deed? Met de opkomst van kunstmatige intelligentie wordt de noodzaak voor een digitale vertrouwensarchitectuur dus nog groter. (Zie ons dossier ‘De Toekomst van Vertrouwen’)

💭 Bewustzijn — Of AI’s bewust kunnen zijn en zo ja, wat dat zou betekenen, is een langlopende fascinatie. Los van de filosofische discussie hierover, worden de gesprekken met AI’s nu dermate diepgaand en overtuigend, dat sommigen stellig geloven dat ze te maken hebben met een echt denkend en voelend persoon. Zo trad Blake Lemoine, een Google-ingenieur en priester, deze maand naar buiten met de overtuiging dat LaMDA, de AI-chatbot die hij moest controleren op discriminatie en haat, daadwerkelijk een bewuste entiteit was. Lees hier zelf Lemoine’s chat met LaMDA. De reactie van vele technici en AI-experts op dit voorval is dat het eerste gevaar van deze interacties met AI’s niet is dat de AI daadwerkelijk bewust is, maar dat wij het als mensen bewustzijn toeschrijven omdat het zó goed social-emotionele patronen herkent, geneert en toepast, dat we als mens denken dat er aan de andere kant van het scherm daadwerkelijk een levend en voelend wezen schuilt.

Dat was het voor deze keer. Fijn weekend allemaal, en tot de volgende.

Veel liefs,

Ed + Chris

Binnen de design wereld is het allemaal nog verder ontwikkeld dan ik hierboven dacht. Check deze recente video van Design Theory, met daarin designers die deze AI tools vandaag al gebruiken:

Met daarin onder andere deze tools (die ik hierboven nog niet noemde):

> Disco Diffusion (Visueel Foundation Model)

> Vizcom (AI teken/schets programma)

> PIFuHD (maakt van 2D mensen beelden, 3D modellen)